Jed White hat in seinem Beitrag auf Search Engine Land wichtige Insights für den Umgang mit AI Search geliefert. Die zunehmende Integration von künstlicher Intelligenz in Suchmaschinen und digitale Assistenten verändert die Art und Weise, wie Inhalte gefunden, verarbeitet und präsentiert werden. Während herkömmliche SEO-Strategien weiterhin von Bedeutung sind, gewinnen neue Optimierungsmethoden an Relevanz, die speziell auf KI-gestützte Suchsysteme ausgerichtet sind. Um sicherzustellen, dass Inhalte in dieser veränderten Suchlandschaft erfolgreich sind, sollten Unternehmen und Website-Betreiber gezielte Anpassungen vornehmen.

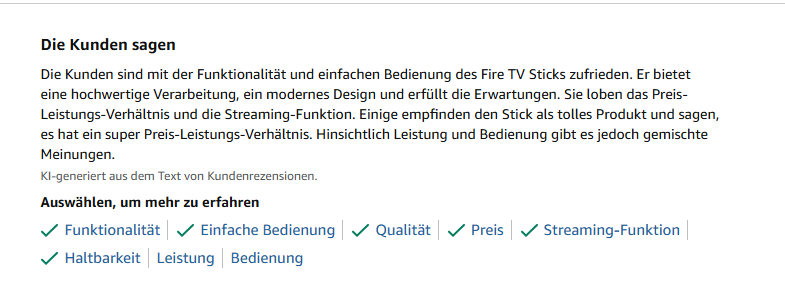

Ein Beispiel, was sicherlich schon vielen aufgefallen ist: Es erscheinen immer mehr KI-Zusammenfassungen auf Websites, in Suchergebnissen oder Shops. Zum Teil wurden diese auch schon in Europa ausgerollt.

Amazon fasst die Nutzerbewertungen kurz und knapp zusammen, sodass man schneller und einfacher eine Kaufentscheidung treffen kann.

Unterschiede zwischen traditioneller SEO und KI-gestützter Suche

Bisher lag der Fokus in der Suchmaschinenoptimierung (SEO) auf der Verwendung relevanter Keywords, der Qualität von Backlinks und der Optimierung technischer Faktoren wie Ladezeiten und mobiler Benutzerfreundlichkeit. KI-basierte Suchsysteme setzen jedoch andere Prioritäten. Durch maschinelles Lernen werden Inhalte analysiert und bewertet, wodurch sich die Kriterien für eine hohe Sichtbarkeit verändern.

Ein entscheidender Unterschied ist die Art und Weise, wie KI-Suchmaschinen Inhalte abrufen und interpretieren. KI-gestützte Systeme bevorzugen klar strukturierte Inhalte, die in einem leicht zugänglichen Format bereitgestellt werden. Während herkömmliche Suchmaschinen HTML-Seiten crawlen und indexieren, verwenden KI-Systeme zusätzlich Large Language Models (LLMs), die Informationen extrahieren und in personalisierten Suchergebnissen wiedergeben.

Darüber hinaus muss man die Geschwindigkeit der Datenverarbeitung im Blick behalten. Viele KI-Suchsysteme operieren unter strengen Zeitvorgaben, weshalb langsame oder schwer zugängliche Inhalte möglicherweise nicht berücksichtigt werden.

Optimierungsstrategien für KI-Suchsysteme

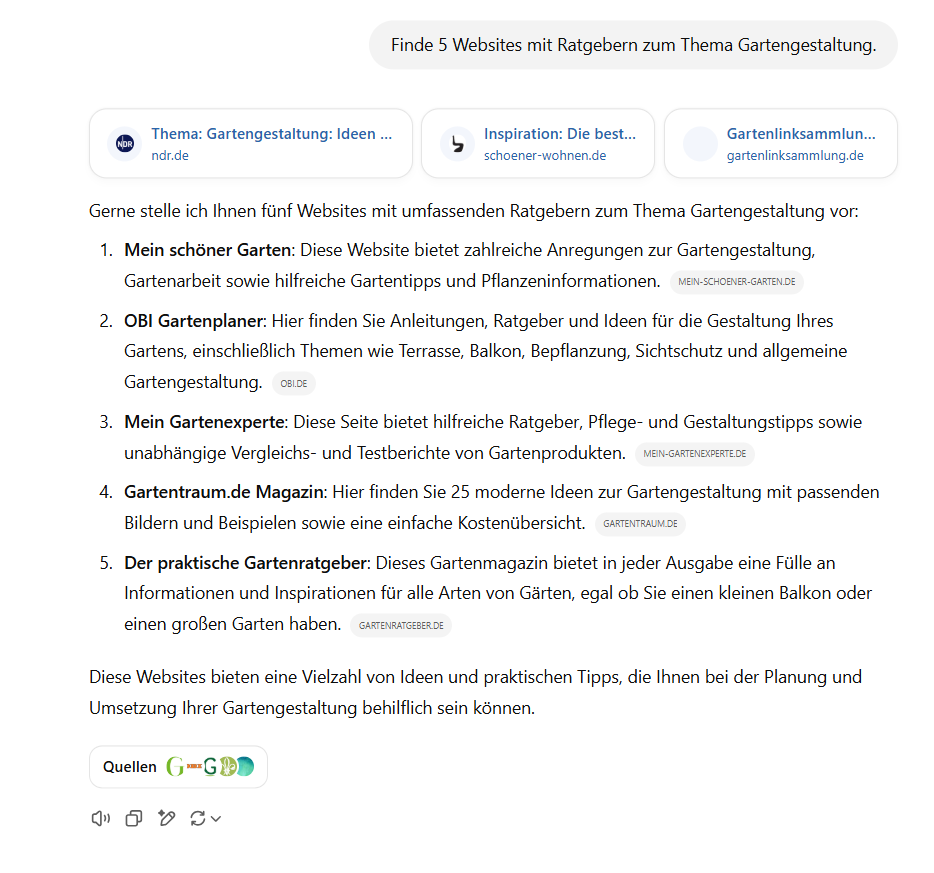

Um Inhalte erfolgreich für KI-gestützte Suchsysteme zu optimieren, sollten verschiedene Anpassungen vorgenommen werden. Zuerst einmal sollten Webmaster die Bots nicht ausschließen. Das hätte den großen Nachteil, dass die KI-Bots nicht auf die Inhalte zugreifen können und diese Seiten weder als Quelle einer AI-Search noch als Basis für Informationen verwendet werden können.

Würde OBI in diesem Fall verbieten, dass der Bot die Website lesen darf, hätte der Konzern einen großen Nachteil. User, die auf diese Weise suchen, finden einen großen Player dann nicht.

Neben dieser Grundlage gibt es selbstverständlich weitere technische Aspekte, die beachtet werden müssen, die Jed genauer analysiert hat.

Klare und strukturierte Inhalte bereitstellen

KI-Suchsysteme bevorzugen gut strukturierte Texte, die in sauberem HTML oder Markdown verfasst sind. Verschachtelte oder unübersichtliche Inhalte können dazu führen, dass wichtige Informationen nicht korrekt interpretiert werden. Eine logische Anordnung von Überschriften, Absätzen und Listen erleichtert die Verarbeitung durch KI-Algorithmen.

Besonderes Augenmerk sollte auf die Vermeidung unnötiger JavaScript-Elemente gelegt werden. Viele KI-Crawler haben Schwierigkeiten, Inhalte zu erfassen, die erst durch JavaScript geladen werden. Falls interaktive oder dynamische Inhalte erforderlich sind, sollte geprüft werden, ob diese auch in einer statischen Form zugänglich gemacht werden können.

Schnelle Ladezeiten gewährleisten

Eine hohe Ladegeschwindigkeit ist ein zentraler Grundstein, da KI-Crawler oft mit begrenzter Zeit arbeiten. Langsame Websites oder Inhalte, die erst nach längerer Ladezeit verfügbar sind, können aus dem Indexierungsprozess ausgeschlossen werden.

Zur Optimierung der Ladezeit sollten unnötige Skripte reduziert, Bilder komprimiert und ein effizienter Server-Cache eingerichtet werden. Inhalte sollten möglichst weit oben auf der Seite platziert werden, damit KI-Crawler die wichtigsten Informationen sofort erfassen können.

Metadaten tragen zur Verständlichkeit von Inhalten durch KI-gestützte Suchmaschinen bei. Durch ein strukturiertes Markup wie schema.org kann man den Inhalt klar definieren und relevante Informationen gezielt hervorheben.

Folgende Maßnahmen sollten berücksichtigt werden:

- Aussagekräftige Titel und Beschreibungen: Präzise Formulierungen helfen KI-Systemen, Inhalte besser zu kategorisieren.

- Datumsauszeichnungen: Aktuelle Informationen können bevorzugt behandelt werden, wenn das Veröffentlichungsdatum korrekt ausgezeichnet ist.

- Semantische HTML-Tags: Die Nutzung von <article>, <header>, <section> und <aside> kann dazu beitragen, die Struktur für KI-Systeme verständlicher zu machen.

Zugänglichkeit für KI-Crawler sicherstellen

Damit KI-gestützte Suchmaschinen Inhalte erfassen können, müssen technische Hürden vermieden werden. Robots.txt-Dateien oder Firewall-Regeln sollten regelmäßig überprüft werden, um sicherzustellen, dass sie den Zugriff für KI-Crawler nicht ungewollt blockieren.

Besondere Aufmerksamkeit sollte auf die Konfiguration von Bot-Schutzsystemen gelegt werden. Sicherheitsmaßnahmen wie reCAPTCHA oder aggressive DDoS-Schutzmechanismen können dazu führen, dass KI-Crawler den Zugriff auf Inhalte verlieren.

Erstellung einer llms.txt-Datei

Ein neues Konzept in der KI-Optimierung ist die Nutzung einer llms.txt-Datei. Diese Datei ermöglicht es Website-Betreibern, bestimmte Anweisungen für KI-Modelle bereitzustellen, beispielsweise welche Inhalte priorisiert oder ignoriert werden sollen. Ähnlich wie robots.txt kann llms.txt dazu beitragen, die Sichtbarkeit in KI-Suchsystemen gezielt zu steuern.

Authentizität und menschliche Perspektiven betonen

Mit der zunehmenden Verbreitung von KI-generierten Inhalten steigt die Bedeutung von authentischen, menschlichen Stimmen. Nutzer und Suchmaschinen legen zunehmend Wert auf Inhalte, die von echten Personen erstellt wurden und persönliche Erfahrungen oder Fachwissen widerspiegeln. Zudem bleibt es spannend, wie dieser User Generated Content (UGC) in diesem Zusammenhang betrachtet werden wird.

Plattformen, die von menschlicher Moderation und echten Diskussionen geprägt sind, gewinnen an Bedeutung. Inhalte, die durch Experten verfasst und mit fundierten Erkenntnissen angereichert werden, haben eine höhere Chance, von KI-Suchsystemen bevorzugt behandelt zu werden.

Es wird zunehmend wichtiger, dass Autoren oder Experten klar erkennbar sind. Autorenseiten mit Verweisen auf Veröffentlichungen, Social-Media-Profile oder akademische Qualifikationen können das Vertrauen in den Inhalt stärken.

Zukünftige Entwicklungen in der KI-Suche

Die Integration von generativer KI in Suchmaschinen schreitet schnell voran. Google hat kürzlich mehrere Updates angekündigt, die KI-gestützte Suchergebnisse verbessern und personalisieren sollen. Neue Features wie die Gruppierung von Suchergebnissen in Kategorien oder interaktive Widgets verändern die Darstellung und Relevanzbewertung von Inhalten.

Diese Entwicklungen verdeutlichen die Notwendigkeit, Inhalte kontinuierlich anzupassen und sich auf neue Algorithmen einzustellen. Die Inhalte müssen also frühzeitig für KI-Suchsysteme optimiert werden. Es ist außerdem wichtiger denn je, seinen Content aktuell zu halten, damit die KI-Bots entsprechende Inhalte an die User weitergeben können.